전 세계 많은 기업들이 예상보다 빠르게 AI를 ITOps 생산성 향상을 위해 수용하고 있습니다. 네트워킹의 이러한 변화를 지원하기 위해 HPE Aruba Networking Central은 AIOps 기능 중 AI Search에 GenAI(생성형 AI) LLM(대규모 언어 모델, Large Language Model) 기술을 탑재합니다.

이 포스팅에서는 최첨단 GenAI 기술이 어떻게 검색에 대한 정확성과 응답을 향상시키는지에 대한 내용과 함께, 네트워킹 공간 내에서 LLM이 어떻게 책임감 있게 구현되고 이전 GenAI 구현과 차별화되는지에 대한 내용을 얘기해볼까 합니다.

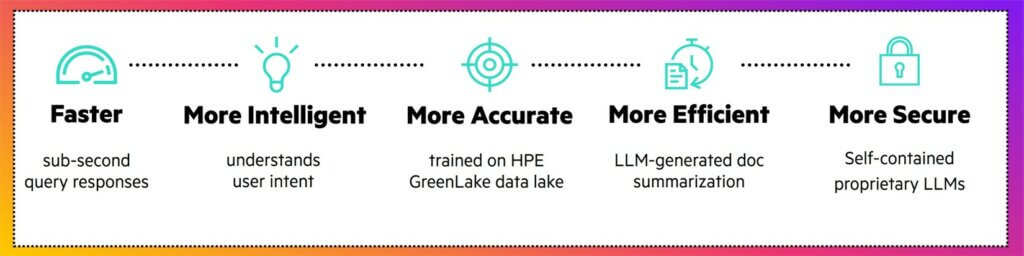

이제 Central 내에서 여러 LLM을 사용함으로써 대화 및 요약 기능을 그 어느 때보다 빠르고 정확하며 안전하게 발전시켜 더욱 강력한 검색 환경을 제공하게 됩니다. 무엇보다도 이러한 새로운 기능의 출시는 4월까지 전 세계 Central 클러스터에 걸쳐 완료됩니다.

AI Search 내의 LLM 개선 사항

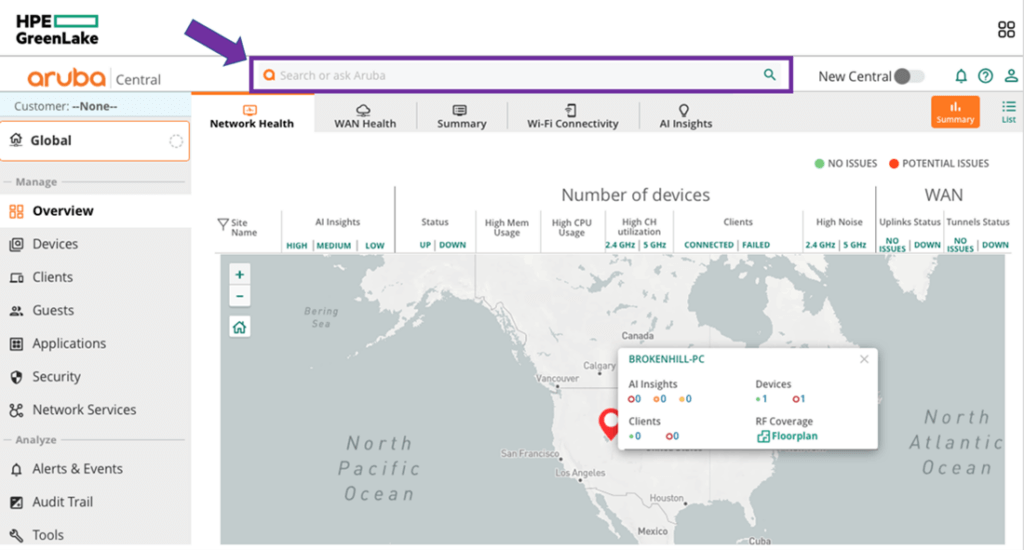

지난 2년 동안, 고급 자연어 처리 기술(NLP)을 활용하여 사용자가 환경에 대한 질문에 대한 답을 쉽게 찾을 수 있도록 설계된 AI Search 기능은 HPE Aruba Central 상단에 배치되었습니다.

HPE의 여러 훈련과 조정을 거친 LLM을 Aruba Central에 통합하여 AI Search를 위한 “엔진 교체”를 하고 있습니다. 교체된 엔진을 통해 기존 AI Search와 동작 방식 느낌은 그대로 유지하면서 검색 정확도, 응답 시간, 데이터 보호 측면에서 최고의 최신 기능을 이용하게 됩니다.

사용자 의도에 따른 검색 정확도 향상

AI Search에 입력된 질문의 의도를 더 잘 이해하기 위해 자체적으로 훈련되고 조정된 LLM Transformer를 활용하고 있습니다.

사용자의 질문 의도를 정확하게 이해하는 것은 더 나은 답변과 사용자 만족도 향상을 위해 가장 중요합니다.

AI Search는 도입 이후 3백만 개 이상의 질문을 받았으며, 이 방대한 기본 데이터 세트를 바탕으로 머신 러닝을 학습시켰습니다.

그 결과, AI Search는 ① 네트워크 전문 용어 질문을 더 잘 이해하고 답변하며, ② 미리 입력된 자동 완성 기능을 제공하고, ③ AI Search 인터페이스에서 바로 GUI의 다른 부분으로 검색 기반 탐색 기능을 도입했습니다.

문서 요약

“너무 내용이 길어서 읽기 어려워요!”

20,000페이지가 넘어가는 Aruba 제품에 대한 기술 문서를 읽지 어렵지 않나요?

이제는 걱정할 필요가 없습니다. Aruba Central의 AI가 도와줄 수 있습니다.

AI Search에 가장 많이 접수되는 질문 유형 중 하나는

네트워킹 제품 내에서 특정 기능을 ‘어떻게’ 구성하거나 활성화하는지에 관한 질문입니다.

이제 AI Search의 GenAI 기능으로 이러한 많은 질문에 대해 사람이 대답하는 것처럼 요약된 답변을 생성하고, 생성 결과의 기반이 되는 참조 문서에 대한 링크도 제공합니다. 이는 네트워크 운영자가 원하는 문서 답변을 찾으려는 시간을 크게 절약할 수 있습니다.

응답 시간

ChatGPT, Gemini 또는 Copilot과 같은 AI 도구들을 사용해 본 사람이라면 각 쿼리마다 장단점이 있다는 것을 이해할 것입니다.

ChatGPT가 사용자의 답변에 응답하는 데 걸리는 몇 초, 향후 학습을 위해 질문 데이터가 Gemini의 데이터 레이크에 ‘기여’하는 정도, 또는 Copilot의 모델을 지속적으로 학습시키는 데 필요한 많은 양의 컴퓨팅 등은 각각의 장단점이 될 수 있습니다.

HPE Aruba는 이러한 장단점을 줄이거나 없애기 위해 여러 가지 특수 목적의 LLM 트랜스포머를 설계하고 활용하고 있습니다.

독립형 LLM을 사용하게 되면서 더 빠른 응답 시간과 더 뛰어난 검색 성능을 제공하게 됩니다.

데이터 프라이버시 최우선

보안을 우선시하고 데이터 프라이버시의 원칙은 HPE Aruba가 하는 일 중에서 가장 중요한 것 중 하나입니다.

또한 이는 좋은 AI의 기본이기도 합니다.

많은 기업에서 ChatGPT와 같은 도구를 사용하면서 개인정보 보호 및 보안에 대한 심각한 우려가 제기되고 있습니다.

이는 당연한 일입니다. 이러한 도구에 입력된 기업의 지적 재산은 개인정보 보호 및 소유권 문제를 야기합니다.

Aruba 엔지니어링 팀은 이 문제에 대해 매우 신중하게 고민하여 보안 우선 원칙(Security-First)을 위반하지 않으면서 GenAI의 발전을 활용할 수 있는 솔루션을 설계했습니다. HPE Aruba Networking Central을 통해 데이터 레이크에 대한 외부 API 쿼리를 막아 데이터 유출 위험 없이 GenAI의 인간 이해 및 생성 특성을 활용할 수 있도록 로컬에서 훈련되고 호스팅된 여러 LLM을 구현했습니다.

특히, 플랫폼은 PII/CII(개인 및 기업 식별 정보)를 식별하는 전용 언어 모델을 보유하고 있습니다.

이 기능을 통해 AI Search는 입력된 기기 및 사이트 이름 쿼리를 더 잘 이해하여 보다 정확한 답변을 제공할 수 있습니다.

또한 이 기능은 학습 데이터 레이크에서 식별된 데이터를 난독화합니다.

HPE Aruba Central을 통해 새로운 AI, LLM 기능을 체험해보세요!

생성형 AI는 놀랍도록 강력하며, 많은 업계는 실제 AIOps 애플리케이션 측면에서 이제 막 시작 단계에 있습니다.

LLM 기반 AI Search는 오늘날의 HPE Aruba Networking Central 사용자에게 큰 이점을 제공할 뿐만 아니라 차세대 Central로 전환하면서 작업 중인 많은 GenAI 사용 사례 중 첫 번째이기 때문에 많은 기대가 쏟아지고 있습니다.

HPE Aruba Networking Central이 제공하는 다른 보안 기능이나 자동화 및 오케스트레이션 기능과 함께 작동 중인 LLM을 경험하고 싶다면, 아래 링크를 통해서 Aruba Central 데모를 신청해보세요!

HPE Aruba Networking Central 데모 신청하기 – [바로가기]