오늘은 데이터센터 네트워크 아키텍처를 한 번 다뤄볼까 합니다.

데이터센터를 설계할 때는 그 목적과 크기, 목적, 향후 확장성 등 많은 요소를 고려합니다.

그리고 그 요소에 맞게 갖고 있는 예산과 시간 등을 고려하여 아키텍처를 설계합니다.

그럼 어떤 아키텍처가 있는지, 그리고 각 아키텍처의 특징과 장단점을 알아보겠습니다.

1-티어(One-Tier) 디자인

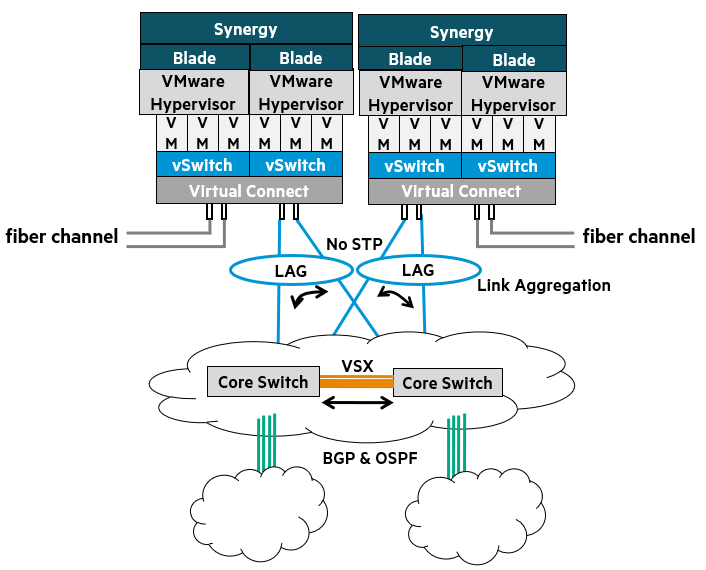

1-티어 디자인은 블레이드 서버 시스템에서 찾아볼 수 있는 독특한 네트워크 아키텍처입니다.

이 디자인에서는 블레이드 인클로저1에 내장된 내부 블레이드 스위치가 ToR2 스위치 역할을 합니다.

이 블레이드 스위치들은 다른 일반적인 ToR 스위치와 마찬가지로 코어 네트워크에 직접 연결됩니다.

1-티어 디자인의 장점

- Layer 2 유연성: 가상 머신(VM)을 자유롭게 이동시킬 수 있으며, IP 주소 변경이 필요 없음

- 관리 복잡성 감소: 관리해야 할 장치(스위치)의 수가 줄어들어 간소화된 네트워크 관리

- STP/RSTP 불필요: VSX3 및 LACP4와 결합하면 루프(Loop)가 없는 네트워크를 구성 가능

- VLAN 관리 최적화: VM 관리에 이상적이며, 자매 데이터센터 간 네트워크 확장 및 VM 이동성 지원

- 중앙 집중식 보안: IP 기반의 IPS5장치를 코어 레이어에 배치하여 중앙에서 보안 관리

이러한 유형의 네트워크 배포는 현재 네트워크 가상화의 정점을 보여줍니다.

블레이드 서버는 랙, 열, 데이터센터당 엄청난 컴퓨팅 밀도를 제공합니다.

HPE는 가상화의 비전과 현실을 지원하기 위해 블레이드 시스템 서버 포트폴리오를 최적화했습니다.

이 네트워크 디자인은 고성능 네트워킹의 현실을 단순성과 함께 최적화합니다.

이는 VM 네트워킹과 컨버지드 I/O 옵션에서 유연성을 제공합니다.

이 접근 방식은 VSX와 Virtual Connect를 모두 활용하므로 가상화를 위한 네트워크 디자인의 최전선에 있습니다.

VM의 원활한 관리 및 문제 해결을 가능하게 하면서도 잘 작동합니다.

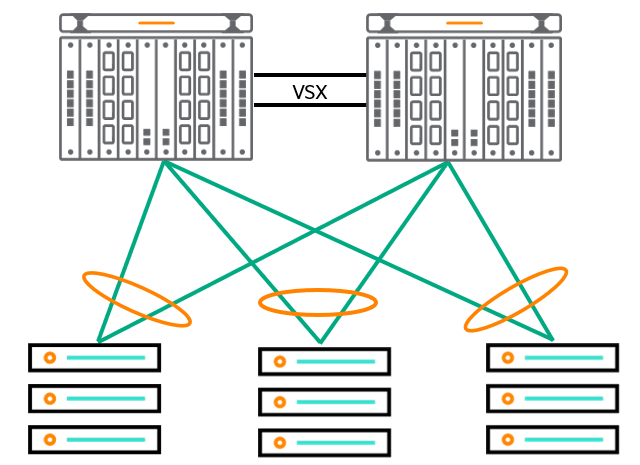

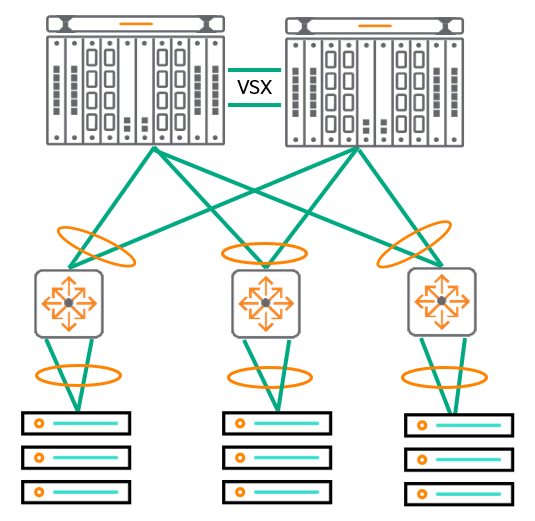

위 그림의 토폴로지는 두 대의 CX 8400 스위치가 최상단에 있고, 이들이 세 대의 서버에 연결되는 구조를 반영합니다.

이는 서버에 연결된 단일 계층의 스위치로 구성된 원-티어 디자인이며, 주로 소규모 데이터센터에서 가장 일반적으로 사용됩니다.

네트워크 엣지는 물리적으로 Virtual Connect에서 시작되지만, 실제로는 VM 내부와 구성된 가상 스위치에서 시작됩니다.

VM과 가상 스위치는 VLAN을 지원하며, 이는 VSX 패브릭과 상호 운용되어 vMotion을 통한 VM의 원활한 이동과 고성능 프레임 포워딩을 가능하게 합니다.

이 디자인에서 LAG6와 VSX를 결합하면 링크 장애 발생 시 50ms 미만의 재수렴 시간으로 고속 링크 어그리게이션을 제공합니다. 또한, 컨버지드 네트워크 어댑터를 통해 모든 스위치에서 링크를 집계하고 활용하여 더 높은 대역폭으로 트래픽을 전달할 수 있습니다.

블레이드 서버는 작은 공간(10 RU)에 많은 컴퓨팅 파워를 집중시켜 기업이 공간을 절약하고, 때로는 전력과 냉각 비용도 절약할 수 있게 합니다. 또한 네트워크를 단순화할 수 있습니다. 여러 랙을 가득 채운 서버와 복잡한 네트워크 토폴로지 대신, 소수의 장비와 단순한 토폴로지로 동일하거나 더 나은 성능을 얻을 수 있습니다.

예를 들어, 이 이미지의 두 블레이드 서버는 최대 32개의 개별 서버를 호스팅할 수 있습니다. 32개 물리 서버라고 상상해 보세요.

이는 64개의 전원 코드(이중화), 64개의 네트워크 연결(이중화), 64개의 파이버 채널 연결을 의미합니다.

이 모든 케이블과 연결을 관리해야 하며, 더 많은 이더넷 포트가 필요하므로 더 많은 스위치가 필요합니다.

이 토폴로지에서는 블레이드 서버와 네트워크 사이에 약 4개의 100Gbps 연결만으로 모든 트래픽을 처리할 수 있습니다.

블레이드 서버 1-티어 디자인의 주요 특징

- 엣지는 물리적으로 Virtual Connect 패브릭에서 시작되지만, 실제로는 VM 및 가상 스위치 내부에서 시작됩니다.

- 블레이드 서버는 랙, 열, 데이터센터당 상당한 컴퓨팅 밀도를 제공합니다.

- 고성능 네트워킹을 최적화합니다.

- 유연한 VM 네트워킹과 컨버지드 I/O 옵션을 제공합니다.

간소화된 2-티어(Two-Tier) 디자인

간소화된 2-티어 디자인은 앞서 설명했던 1-티어 블레이드 디자인과 매우 유사합니다.

주요 차이점은 1-티어 블레이드 디자인이 블레이드 서버를 사용하는 대신, 2-티어 디자인은 전통적인 랙 서버를 사용하고 이를 랙 상단(Top-of-Rack) 스위치에 연결한다는 점입니다.

이 솔루션은 특히 랙 서버와 블레이드 서버를 혼합하여 사용해야 하는 환경에 가장 적합합니다.

기존의 3-티어(Three-tier) 레거시 모델보다 더 평면적인(flatter) 구조를 가지며, 네트워크 지연 시간을 줄여주는 장점이 있습니다.

2-티어 디자인의 목표 및 장점

레이어 2 유연성:

IP 주소를 변경할 필요 없이 가상 머신(VM)을 이동시킬 수 있는 유연성을 제공합니다.

장거리 vMotion(Long-range vMotion)을 지원하여 물리적으로 떨어진 데이터센터 간에도 VM을 쉽게 마이그레이션할 수 있습니다.

관리 복잡성 감소:

대형 어그리게이션 스위치를 사용하여 네트워크 구조를 평면화합니다.

관리해야 하는 장치(스위치)의 수가 줄어들어 네트워크 관리가 더욱 간소해집니다.

스패닝 트리 의존도 감소:

HPE는 네트워크 최적화와 단순화를 위해 VSX 사용을 권장합니다.

VSX는 루프 없는 환경을 제공하여 스패닝 트리(Spanning Tree) 프로토콜에 대한 의존도를 줄여줍니다.

VLAN 관리:

데이터센터 전반에 걸친 VM 이동성 확장(VM mobility extension)을 위한 프레임워크를 제공하여, VM이 물리적 위치와 상관없이 네트워크에 연결될 수 있도록 돕습니다.

중앙 집중식 보안:

레이어 2 네트워크는 VLAN이 집계되는 코어 레이어에 IP 기반의 IPS(침입 방지 시스템) 장치를 배치할 수 있도록 하여 보안 관리를 중앙 집중화할 수 있습니다.

간소화된 투-티어 디자인은 유연성, 관리 용이성, 그리고 성능 향상이라는 측면에서 현대 데이터센터의 요구사항을 충족시키는 효과적인 네트워크 아키텍처라고 할 수 있습니다.

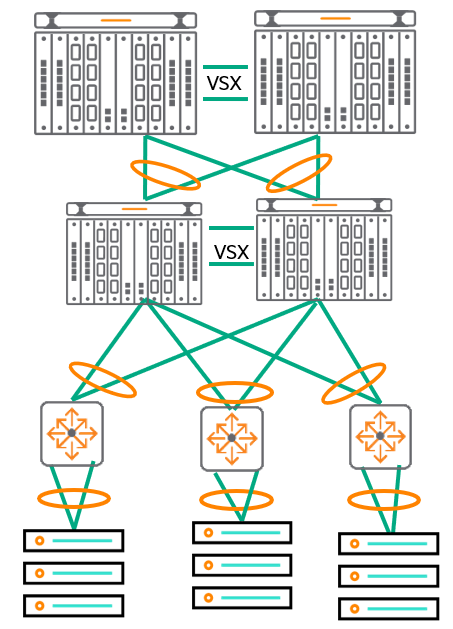

3-티어(Three-Tier) 디자인: 전통적인 계층형 데이터센터 네트워크

3-티어 디자인은 데이터센터 네트워크에서 가장 전통적이고 널리 사용되어 온 아키텍처입니다.

이 디자인은 액세스 레이어와 코어 레이어 사이에 ‘어그리게이션(Aggregation) 레이어’를 추가합니다.

이러한 구조에서는 많은 ToR(Top-of-Rack) 스위치들이 소수의 어그리게이션 레이어 스위치에 연결됩니다.

그리고 이 어그리게이션 레이어 스위치들은 다시 이중화된 코어 스위치에 듀얼 홈드(dual homed) 방식으로 연결됩니다.

(즉, 각각의 어그리게이션 스위치가 두 개의 코어 스위치에 연결되어 이중화를 제공합니다.)

현대의 데이터센터는 10GbE, 25GbE, 40GbE 포트 용량과 같은 추가적인 대역폭을 요구합니다.

3-티어 디자인은 간소화된 관리 스위트(suite)와 잘 어울리며, 기존의 EoR(End-of-Row) 및 ToR 스위치와의 상호 운용성을 보장하는 데 도움이 됩니다.

3-티어 디자인의 목표 및 장점

- 레이어 2 유연성: IP 주소를 변경할 필요 없이 가상 머신(VM)을 이동시킬 수 있는 유연성을 제공

- 최적화된 관리 복잡성: VSX를 다양한 계층에서 사용하여 네트워크를 단순화하고 관리 복잡성을 최적화

- 스패닝 트리 의존도 감소: 네트워크 최적화 및 단순화를 위해 VSX와 LAG 사용을 권장

- VLAN 관리: 사이트 간 네트워크 확장을 지원하여 VM 이동성을 가능하게 함

비록 제시된 디자인이 AOS-CX 스위치에 중점을 두고 있지만, VSX 기능은 어떤 레벨에서든 서드파티(타사) 스위치를 추가하는 것을 허용하며, 표준 기반 네트워킹을 사용하여 상호 운용될 수 있습니다. 이는 기존 장비를 활용하거나 특정 벤더에 종속되지 않는 유연성을 제공한다는 의미입니다.

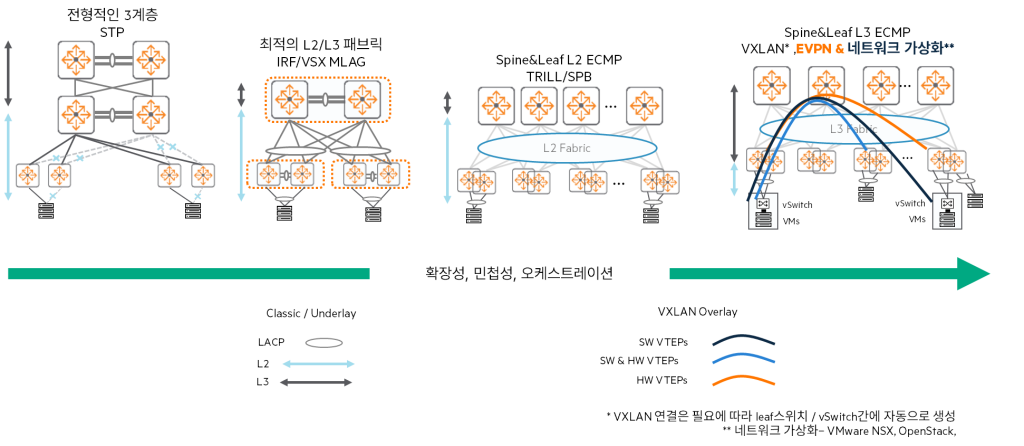

데이터센터 네트워크 아키텍처의 진화: STP에서 L3 패브릭까지

데이터센터 네트워크 아키텍처는 지난 몇 년간 끊임없이 발전해 왔습니다.

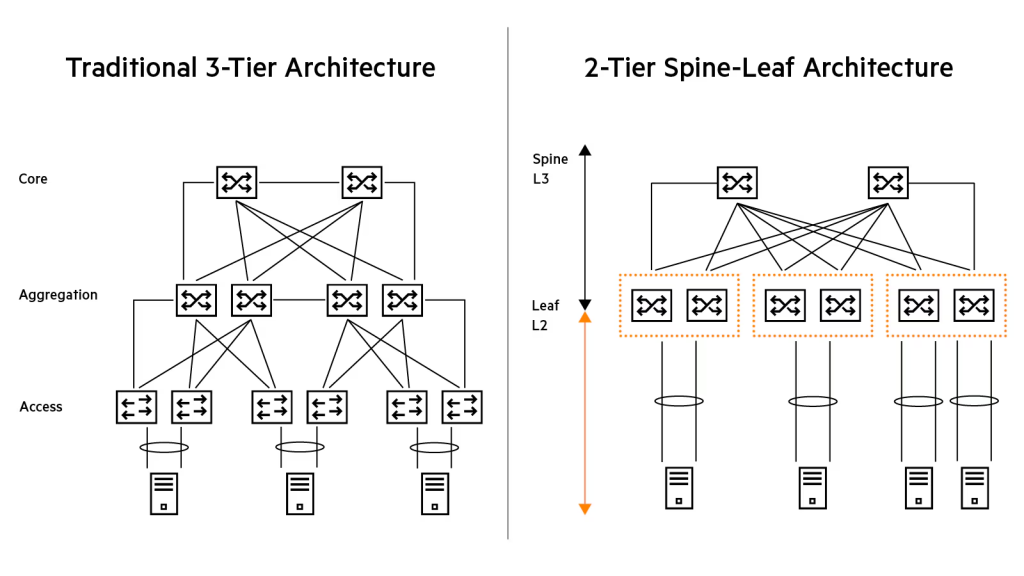

1. 전통적인 3계층 (Three-Layer)

과거에는 전통적인 쓰리-레이어(액세스-어그리게이션-코어) 아키텍처를 사용했습니다.

이때는 토폴로지를 제어하고 루프를 방지하며, 링크 또는 스위치 장애 발생 시 네트워크가 자동으로 복구되도록 STP7와 같은 데이터센터 프로토콜을 사용해야 했습니다.

하지만 이 방식은 사용되지 않는 링크 발생, 느린 컨버전스(복구 시간), 다중 경로(multi-pathing) 미지원, 그리고 확장성 제약 등의 문제로 인해 네트워크 설계자들이 빠르게 외면하고 있습니다.

2. 최적화된 2계층 (Optimized Two-Layer)

전통적인 3계층의 선택적 대안으로 최적화된 투-레이어 아키텍처가 등장했습니다.

이 방식은 HPE Aruba Networking VSX와 같은 프로토콜을 스택하고, MLAG8를 분산하여 액티브-액티브(active-active) 링크를 통한 더 나은 링크 활용률과 로드 쉐어링을 가능하게 합니다.

하지만 최적화된 2계층에서도 데이터센터의 대형 코어 스위치에서 높은 대역폭 수요를 충족시키기 위해 여전히 STP와 같은 프로토콜이 필요하며, 업링크는 여전히 업그레이드 및 확장성 제약을 발생시킵니다.

3. 스파인-리프(Spine and Leaf) 토폴로지

스파인-리프 토폴로지는 TRILL9 및 SPBM10과 같은 프로토콜을 사용하여 데이터센터 네트워크의 문제점들을 해결합니다.

- 스파인-리프는 대규모 L2 패브릭을 생성하여 VM이 인프라 변경 없이 DCN 전반에 걸쳐 이동 가능

- L3 언더레이(Underlay) 위에서 L2 패킷을 전송하고 ECMP11 로드 밸런싱을 제공함으로써 업링크 활용도를 향상

- 하지만 장애 격리가 안 되고, 오버레이 컨트롤 플레인(flood and learn)의 제약12이 있으며, 멀티사이트 지원이 불가능

4. L3 패브릭 (Layer 3 Fabrics)

최근에는 스파인-리프 아키텍처에서 한 번 더 진화하여 VXLAN, EVPN, 그리고 MP-BGP를 활용하는 L3 패브릭이 등장했습니다.

- 장점: VM 이동성, 대규모 DCN 지원, 장애 격리(Fault Containment), L2 및 L3에서의 멀티테넌시(VPN) 지원

- 단점: 패브릭 가시성이 감소하고 문제 해결 복잡성이 증가하는 등의 한계성

네트워크 패브릭의 장점 및 확장성

네트워크 패브릭은 수천 대의 서버를 연결하고 고대역폭과 안정적인 연결을 제공하는 대규모 네트워크 생성을 가능하게 합니다.

- 네트워크 패브릭(스파인-리프)을 확장하고 싶다면, 스파인 스위치가 지원하는 만큼(스위치 포트 수를 고려하여) 리프(leaf) 스위치를 추가하기만 하면 됩니다.

- 더 많은 대역폭이 필요하다면 스파인 스위치와 업링크를 더 추가하면 됩니다.

- 모든 리프 스위치와 스파인 스위치는 동일한 속도의 라우팅된 인터페이스로 연결되므로, ECMP가 사용 가능한 모든 업링크를 통해 로드를 균등하게 분산시킵니다.

이 토폴로지의 가장 큰 장점은 낮은 지연 시간(low latency)입니다.

각 리프 스위치는 최대 1홉(one-hop) 만에 다른 리프 스위치에 도달할 수 있기 때문입니다.

이는 데이터센터 내 동-서(East-West) 트래픽에 매우 유리합니다.

스파인-리프(Spine and Leaf) 디자인: 현대 데이터센터 네트워크의 핵심

스파인-리프 디자인은 현대 데이터센터 네트워크(DCN)에서 가장 진보된 토폴로지 중 하나입니다.

이 디자인은 라우팅 언더레이(Underlay)를 기반으로 하며, 이 언더레이는 일반적으로 OSPF 또는 iBGP를 사용하여 액세스(리프) 레이어와 코어(스파인) 레이어를 연결합니다. 그 위에서 VXLAN 캡슐화 오버레이를 통해 L2 패킷을 L3 네트워크를 통해 전송합니다.

전통적인 L2 디자인과의 차이점

이 디자인은 전통적인 L2 디자인과 비교했을 때 다음과 같은 큰 차이점을 가집니다:

- 라우팅된 링크 사용: 리프와 스파인 사이에 L2 링크 대신 라우팅된(L3) 링크가 사용

- ECMP 로드 쉐어링: ECMP가 트래픽 분산 목적으로 사용

- 라우팅 프로토콜을 통한 이중화: 여러 연결과 라우팅 프로토콜을 활용하여 이중화

- 루프-프리(Loop-Free): 스파인과 리프 사이에 브로드캐스트 도메인이 없음

스파인-리프의 핵심 원칙 및 장점

- 모든 리프는 모든 스파인 스위치에 연결

- 스파인 스위치 간 직접 연결 없음

- 대역폭 확장 용이: 스파인 스위치를 추가하기만 하면 사용 가능한 대역폭 확장 가능

- 낮은 지연 시간

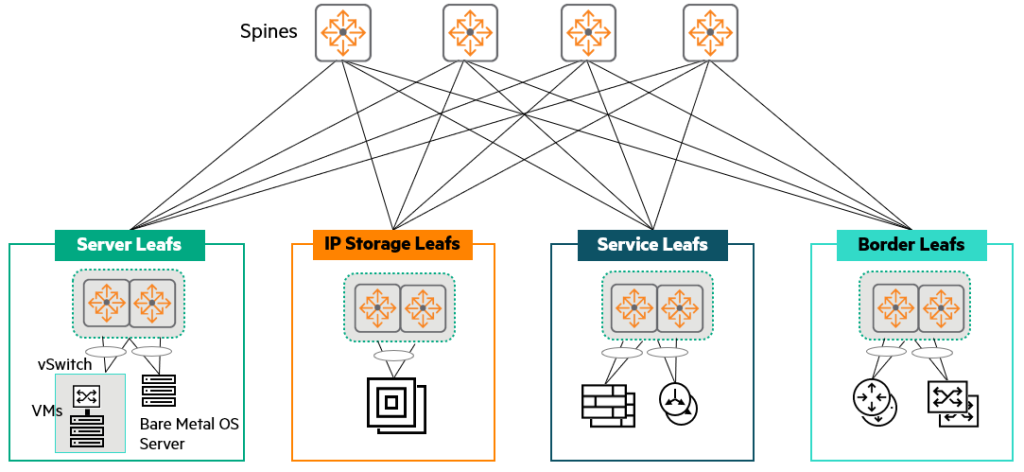

서비스 분배: 리프 유형

스파인-리프 토폴로지에서는 서비스를 리프 스위치에 분산시키는 방법으로 일반적으로 다음 네 가지 유형의 리프를 사용합니다.

- 서버 리프(Server leafs): 물리적 서버(베어 메탈) 및 가상화된 서버를 포함하여 서버가 직접 연결되는 리프

- IP 스토리지 리프(IP Storage leafs): 서버와 IP 스토리지가 동일한 랙에 있을 때, 랙당 하나의 데이터센터 네트워크에 최적화된 스위치 쌍이 리프 기능을 제공

- 서비스 리프(Service leafs): 로드 밸런서, 방화벽, IPS와 같은 네트워크 서비스를 호스팅하는 전용 리프

- 경계 리프(Border leafs): 기업 LAN 또는 WAN과 같이 하나의 패브릭을 다른 패브릭에 연결하는 리프 스위치.

중앙 집중식 네트워크 서비스와 DCN 내의 규모 및 장애 구역 설계에 따라 경계 리프가 서비스 리프 역할도 수행 가능

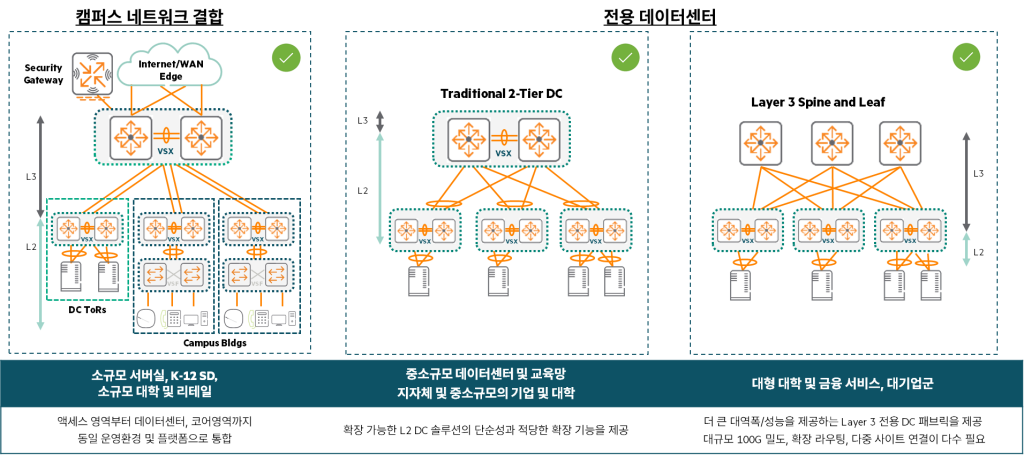

기존 토폴로지의 유효성

스파인-리프가 가장 진보되고 권장되는 토폴로지이지만, 이는 전통적인 1-티어, 2-티어 또는 3-티어 토폴로지가 더 이상 유효하지 않다는 것을 의미하지 않습니다. 많은 고객들이 다양한 이유로 여전히 이러한 토폴로지를 운영하고 배포하고 있습니다.

- 소규모 및 중소기업: 1-티어 토폴로지를 사용할 수 있으며, 여기서는 코어 레이어가 서버, 블레이드 서버 및 스토리지에 직접 연결됩니다. 이는 비즈니스에 단순성, 낮은 지연 시간 및 안정성을 제공합니다.

- 중대형 기업: 레거시 인프라 및 프로토콜과의 하위 호환성을 유지해야 하는 경우, 2-티어 및 3-티어 토폴로지가 여전히 자주 사용됩니다.

각 디자인의 주요 특징 요약

스파인-리프 데이터센터:

- 랙/리프 간 Layer 3를 사용하므로 STP가 필요 없습니다.

- ECMP 라우팅이 리프 간 트래픽을 로드 쉐어링합니다.

- 모듈형/고정 포트 스파인 스위치 사용 가능하며, 이는 패브릭의 확장 크기를 결정합니다.

- 리프에서 서버로의 링크 어그리게이션이 트래픽 로드 쉐어링과 링크/스위치 이중화를 제공합니다.

1-티어 데이터센터:

- 모듈형/고정 포트 코어 스위치 사용 가능하며, 이는 연결할 수 있는 서버 수를 결정합니다.

- 코어에서 서버로의 링크 어그리게이션이 트래픽 로드 쉐어링과 링크/스위치 이중화를 제공합니다.

2-티어 데이터센터:

- 모듈형/고정 포트 코어 스위치 사용 가능하며, 이는 사용할 수 있는 액세스 스위치 수를 결정합니다.

- 액세스/코어 간 링크 어그리게이션이 트래픽 로드 쉐어링과 링크/스위치 이중화를 제공하므로 루프-프리 토폴로지를 이룹니다.

- STP는 루프를 방지하는 백업 메커니즘으로 활성화됩니다.

- 액세스 스위치에서 서버로의 링크 어그리게이션이 트래픽 로드 쉐어링과 링크/스위치 이중화를 제공합니다.

고객의 데이터센터 네트워크 설계 방법

고객의 데이터센터 네트워크를 설계하는 방법은 두 가지 시작점에서 출발할 수 있습니다.

- 제품 및 혁신적인 기능 제시: 먼저 최신 제품과 혁신적인 기능을 고객에게 소개하고, 이러한 기술이 고객의 문제를 어떻게 해결할 수 있는지 보여주는 방식입니다.

- 질문 및 요구사항 파악: 고객의 현재 상황과 필요에 대한 질문을 통해 핵심 요구사항을 파악하고, 이를 바탕으로 맞춤형 설계를 제안하는 방식입니다.

대부분의 경우, 고객의 진정한 필요를 파악하기 위해 두 번째 접근 방식(질문 및 요구사항 파악)부터 시작하는 것이 좋습니다.

1. 주요 이슈/문제점 파악을 위한 질문

가장 먼저 고객이 현재 겪고 있거나 예상하는 주요 문제점이나 요청의 근본적인 이유를 파악하는 것이 중요합니다.

이 요청의 주된 동기는 무엇입니까?

- 현재 장비의 기술 지원 종료(End of Support)가 임박하여 새로운 데이터센터 네트워크로 마이그레이션해야 합니까?

- 현재 제조사에 대한 불만(지원 부족, 버그 등)이 많습니까?

- 확장성, 포트 밀도, 대역폭 문제에 봉착했습니까?

- 새로운 POD(Point of Delivery) 또는 몇 개의 새로운 랙으로 데이터센터를 확장해야 합니까?

- 새로운 데이터센터 네트워크로 마이그레이션해야 합니까? 마이그레이션 기한이 있습니까?

2. 고객이 이미 제공한 요구사항

혹은 고객이 이미 본인의 요구사항을 RFP 등을 통해 제시했을 수 있습니다. 이는 설계의 방향을 결정하는 데 매우 중요합니다.

- 데이터센터에서 STP(Spanning Tree Protocol)를 없애고 싶다.

- 네트워크가 VMware NSX와 통합되어야 한다.

- 서버의 IP 주소를 재할당하지 않고 마이그레이션해야 한다.

- 여러 데이터센터 간에 vMotion VM을 사용할 수 있어야 한다.

(몇 개의 데이터센터인지? WAN 인프라는 어떻게 되어 있는지?) - 향후 3년 내에 온프레미스 데이터센터를 20% 확장할 것으로 예상한다.

(물리적 확장보다는 서버 하드웨어 역량, VM, 컨테이너로의 전환을 통해 확장하고 싶다.) - 데이터센터의 가동 시간(uptime)은 99.999%여야 한다. (연간 최대 5분 15.6초의 다운타임만 허용)

- 기존 IRF 코어 스위치가 버그로 인해 다운된 경험이 있다. 미래에 이런 상황을 어떻게 피할 수 있는가?

3. 현재 운용 중인 데이터센터에 관한 질문

기존 인프라를 이해하는 것은 새로운 설계를 위한 중요한 기초입니다.

- 현재 네트워크 토폴로지는 무엇입니까? (예: 3-티어, 2-티어, 스파인-리프 등)

- 현재 장비의 설정값(config output)을 제공해 주실 수 있습니까?

- 현재 VM은 몇 대이고, 물리 서버는 몇 대입니까?

- 대부분의 서버가 이중화된 ToR 스위치에 LACP를 활용하여 연결되어 있습니까?

4. 새로운 데이터센터 요구사항에 대한 질문

새로운 데이터센터에 대한 구체적인 기술적 요구사항을 심층적으로 파악합니다.

- 현재 IPv4와 IPv6를 모두 사용해야 합니까? 아니면 현재는 IPv4만, 미래에 IPv6를 사용할 예정입니까?

- 멀티캐스트 라우팅을 활용합니까? (예: PIM-SM, PIM-SSM 등)

- 현재 사용 중인 라우팅 프로토콜은 무엇입니까?

- 랙 간에 L2 연결이 필요합니까?

- 애플리케이션이 랙 간에 L3 연결을 활용할 수 있습니까?

(즉, 애플리케이션이 L3 경계를 넘나들 수 있도록 설계되었는지?) - 데이터센터 내 애플리케이션이 네트워크에 요구하는 것은 무엇입니까?

(예: 특정 대역폭, 지연 시간, 특정 서비스 품질 등) - 스토리지 네트워킹은 어떻게 됩니까?

(예: iSCSI, FC, FCoE, RoCE 등 어떤 기술을 사용하거나 사용할 예정입니까?) - 새로운 데이터센터에 필요한 속도는 무엇입니까?

스위치 간 연결은 40G 또는 100G 링크가 필요합니까?

서버로의 연결은 1G, 10G 또는 25G가 필요합니까? - 필요한 연결 유형은 무엇입니까?

스위치 간 DAC(Direct Attach Cable)을 사용합니까 아니면 광섬유를 사용합니까?

서버로의 연결은 UTP, DAC 또는 광섬유 어떤 케이블을 사용합니까? - 어떤 종류의 확장성이 필요합니까? IPv4(IPv6) 라우팅/MAC/ARP 테이블 규모

- 현재 필요한 총 서버 포트 수는 몇 개입니까?

- 서버가 듀얼 ToR 스위치에 MLAG13로 연결될 예정입니까?

- 성장에 대비하여 몇 개의 예비 포트가 필요합니까?

- ToR 스위치에서의 목표 오버서브스크립션(oversubscription) 비율은 얼마입니까?

- 필수적인 소프트웨어 기능은 무엇입니까? VXLAN/EVPN이 필수입니까?

이러한 수많은 질문들을 통해 고객의 현재 상황과 미래 목표를 깊이 이해해야 합니다.

그리고 이를 바탕으로 최적의 데이터센터 네트워크 아키텍처와 솔루션을 설계할 수 있습니다.

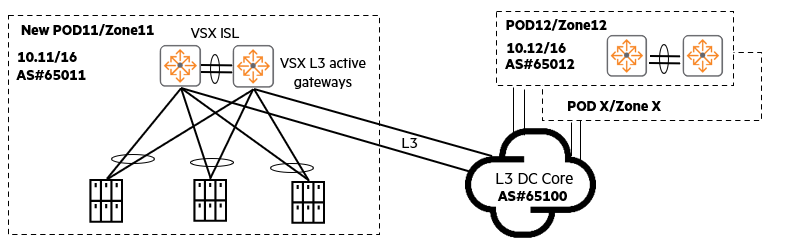

데이터센터 POD: 안정성과 효율성을 위한 모듈형 접근 방식

만약 고객의 가장 큰 걱정과 필요가 애플리케이션의 네트워크 가동 시간, 네트워크 문제의 영향(장애 범위) 최소화, 그리고 네트워크 문제의 신속한 진단 및 해결 능력이라면, 가장 추천하는 해결책은 바로 POD(Point of Delivery)14 기반 아키텍처입니다.

일부 조직에서는 여러 데이터센터를 운영하는데, 이때 이 데이터센터들을 종종 POD 또는 가용성 영역(Availability Zones)이라고 부릅니다. POD 기반 아키텍처는 다음과 같은 특징을 가집니다:

- 동일 애플리케이션의 최적 배치: 유사하고 가장 빠른 동-서(East-West) 네트워크 연결이 필요한 애플리케이션은 동일한 POD 내부에 배치해야 합니다.

- 애플리케이션별 POD 분리: 서로 다른 애플리케이션은 각기 다른 POD에 배치할 수 있습니다.

- 북-남(North-South) 트래픽 흐름: 최종 사용자로부터 발생하는 북-남 트래픽은 L3 데이터센터 코어를 통과합니다.

- POD 내 L2 격리: 각 POD는 자신만의 L3 서브넷을 가집니다. L2(레이어 2) 연결은 POD 내부로만 제한되어 L2 네트워크 문제나 브로드캐스트 트래픽이 외부로 확산되는 것을 방지합니다.

- 유연한 POD 크기: 하나의 POD는 하나의 랙, 두 개의 랙, 심지어 10개 랙으로 구성된 전체 열을 아우를 수도 있습니다.

POD 기반 아키텍처의 장점

- 최대 네트워크 고가용성 및 가동 시간: 한 POD에서 네트워크 문제가 발생해도 다른 POD에는 영향을 미치지 않아 전체 시스템의 안정성이 높아집니다.

- 독립적인 업그레이드: 각 POD를 독립적으로 업그레이드할 수 있어 서비스 중단 위험을 줄이고 유지보수를 유연하게 할 수 있습니다.

- 유연한 POD 구성: POD는 매우 유연합니다. 예를 들어, 1-티어, 2-티어 액세스 코어, 2-티어 리프/스파인, 또는 POD 내에서 VXLAN을 사용하는 등 다양한 유형의 POD를 활용할 수 있습니다.

POD 기반 아키텍처는 데이터센터의 복잡성을 관리하고, 장애 발생 시 영향을 최소화하며, 전반적인 서비스 안정성을 극대화하는 데 매우 효과적인 전략입니다.

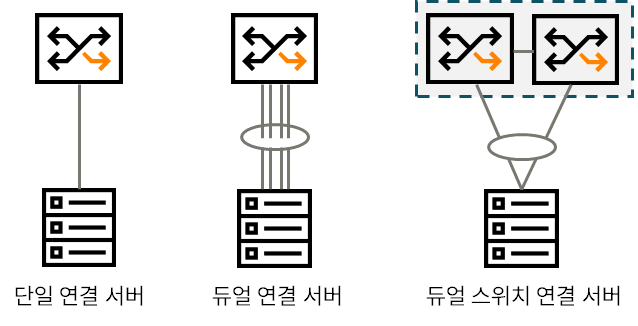

서버 연결 방식: 안정적인 데이터센터 구축을 위한 필수 고려사항

데이터센터 설계를 진행할 때, 서버(또는 엔드포인트)를 어떻게 네트워크에 연결할지는 간단하지만 매우 중요한 단계입니다.

서버 연결 방식을 선택하는 것은 데이터센터 네트워크의 가용성, 복원력, 그리고 성능에 직접적인 영향을 미치기 때문입니다.

1. 단일 연결 서버 (Single Attached Server)

서버에 하나의 네트워크 카드(NIC)와 하나의 케이블을 사용하여 스위치에 연결하는 방식입니다.

- 장점: 스위치 포트와 케이블을 절약할 수 있습니다.

- 단점: 이중화 및 복원력이 부족합니다. 해당 NIC, 케이블 또는 스위치 포트에 장애가 발생하면 서버는 네트워크에서 완전히 단절됩니다.

2. 듀얼 연결 서버 (Dual Attached Server)

서버에 두 개 이상의 NIC와 케이블을 사용하여 하나의 스위치에 연결하는 방식입니다.

- 장점: NIC와 케이블에 대한 링크 이중화를 제공합니다. 또한, 링크 어그리게이션(Link Aggregation)과 같은 기술을 사용하여 대역폭을 증가시킬 수 있습니다.

- 단점: 연결된 스위치 자체에 장애가 발생하면, 서버 전체가 네트워크에서 사용할 수 없게 됩니다.

3. 듀얼 스위치 연결 서버 (Dual-Switch Attached Server) – HPE 권장 방식

두 개 이상의 서버 NIC를 서로 다른 스위치에 연결하는 방식으로 HPE는 이 방식을 권장합니다.

이 방식은 아래와 같은 장점을 제공합니다.

- 링크, NIC, 그리고 스위치 이중화를 모두 제공합니다.

하나의 스위치에 문제가 발생해도 다른 스위치를 통해 서비스 연속성을 유지할 수 있습니다. - 링크 어그리게이션과 결합하면 서버에 더 많은 대역폭을 제공하여 성능을 향상시킬 수 있습니다.

이번 포스팅에서는 데이터센터 네트워크를 설계하기 위해 알아야 할 구조를 살펴보았습니다.

IT 기술이 발전하고 그에 따라 데이터 처리 방식, 컴퓨터 환경 등도 바뀌었습니다. 이에 맞춰 당연히 네트워크도 발전해왔습니다.

오랜 세월동안 축적된 기술과 지식들이 데이터센터의 환경과 설계도 바꾸고 있습니다.

트렌드를 이해하기 위해서는 앞서 어떤 디자인이 있었고 어떠한 장단점이 있는지도 함께 숙지해야 할 것입니다.

무작정 최신의 기술만이 정답이고, 반드시 채택해야 하는 것은 아니기 때문입니다.

- 서버들을 담는 물리적 함체 ↩︎

- Top of Rack ↩︎

- Virtual Switching eXtension ↩︎

- Link Aggregation Control Protocol ↩︎

- 침입 방지 시스템 ↩︎

- Link Aggregation Group ↩︎

- Spanning Tree Protocol ↩︎

- Multi-Chassis Link Aggregation ↩︎

- Transparent Interconnection of Lots of Links ↩︎

- Shortest Path Bridging for Media ↩︎

- Equal-Cost MultiPath ↩︎

- 브로드캐스트 도메인의 호스트 수가 증가할수록 플러딩 패킷의 부정적인 영향이 커짐 ↩︎

- Multi-chassis Link Aggregation Group ↩︎

- 여러 개의 서버 랙과 네트워크 장비, 스토리지 등이 모여 하나의 독립적인 서비스 단위를 구성하는 모듈형 아키텍처 ↩︎